Os computadores estão profundamente integrados à nossa realidade, sustentando as bases de dados de bilhões de pessoas e empresas. A tecnologia molda não apenas os negócios, mas também a vida diária, e o avanço dos smartphones trouxe a interação humano-máquina para a palma das nossas mãos. No entanto, essa conexão tão íntima é um fenômeno recente na história.

Apenas duas décadas atrás, vivíamos em um mundo bem diferente. Os celulares, ainda longe de se tornarem multifuncionais, eram usados principalmente para ligações e mensagens de texto, enquanto os computadores eram ferramentas de trabalho mais do que de lazer. A Inteligência Artificial, que hoje faz parte do cotidiano, era restrita a laboratórios e um conceito distante para a maioria das pessoas.

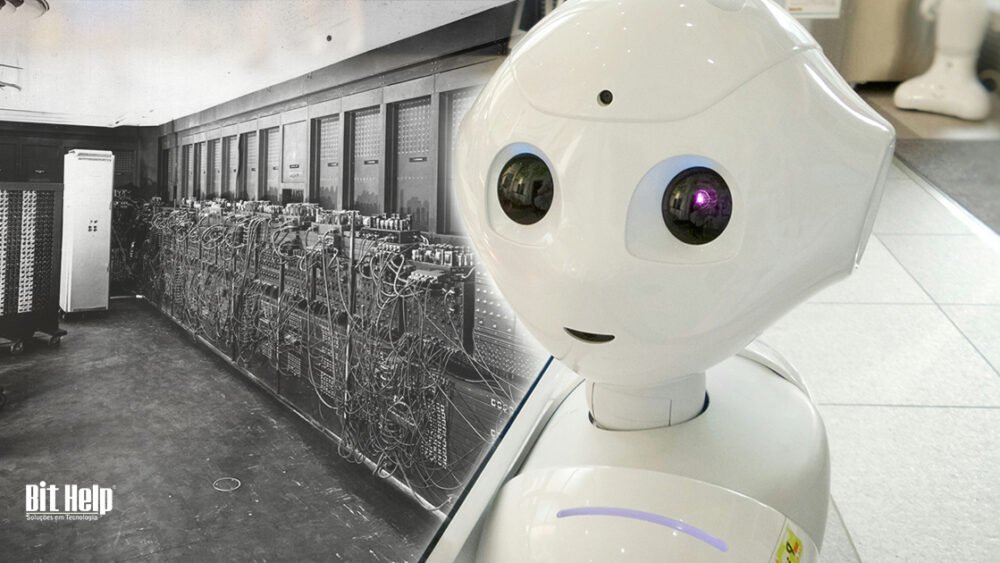

A transformação tecnológica foi surpreendentemente rápida, mas como tudo isso começou? Neste artigo, convidamos você a viajar no tempo, desde os primeiros passos da computação com o monumental ENIAC até os avanços de ponta, como a computação quântica. Prepare-se para explorar como a evolução dos computadores moldou o mundo como o conhecemos e promete redefinir nosso futuro!

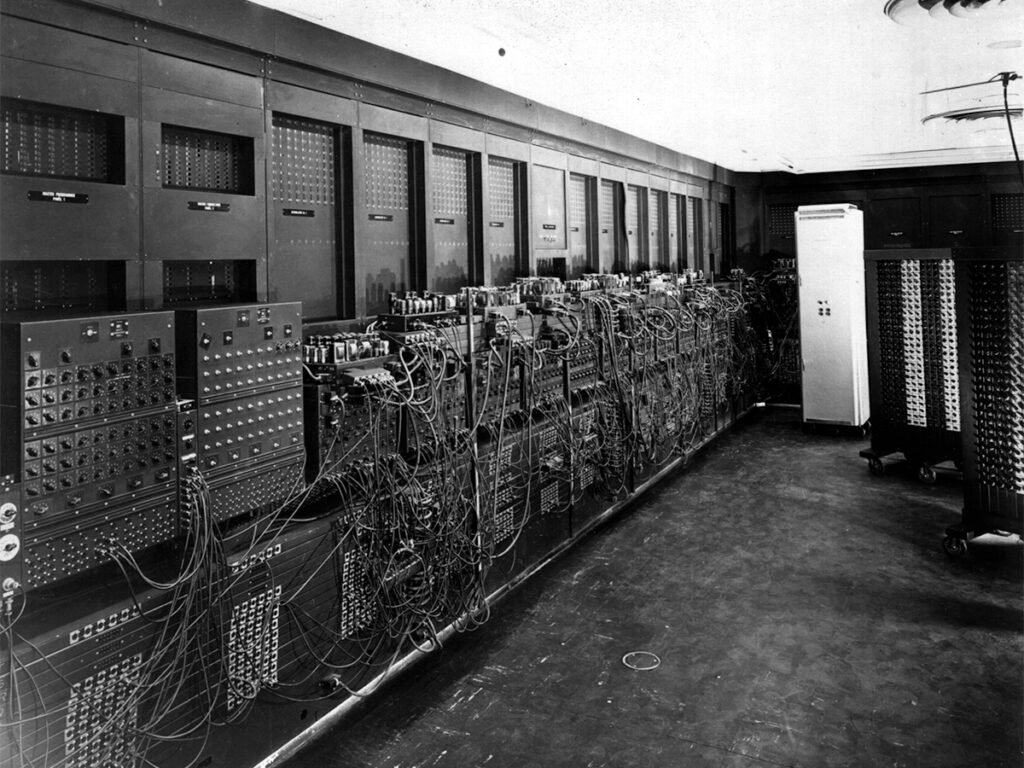

ENIAC: O gigante que impulsionou a Era da computação

Em fevereiro de 1946, os cientistas John Presper Eckert e John Mauchly apresentaram ao mundo o Electronic Numerical Integrator And Computer, ou ENIAC, um marco na história da tecnologia. Com impressionantes dois metros de altura e 30 toneladas de peso, o ENIAC ocupava 180 metros quadrados, era movido por 18 mil válvulas a vácuo e consumia cerca de 200 mil watts de energia. O custo de sua produção foi de US$500 mil – o equivalente a cerca de US$8 milhões hoje.

O projeto começou em 1943, financiado pelo exército dos Estados Unidos, com o objetivo de realizar cálculos no laboratório de pesquisas balísticas durante a Segunda Guerra Mundial. No entanto, o ENIAC só foi concluído após o fim do conflito. Apesar de sua capacidade inovadora para a época, sua performance era limitada: ele realizava cálculos simples e sua programação precisava ser refeita manualmente a cada nova tarefa, utilizando cartões perfurados, fios e interruptores.

Hoje sabemos que a programação do ENIAC foi realizada inteiramente por mulheres, as primeiras programadoras da história. Kathleen Antonelli, Jean Bartik, Frances “Betty” Holberton, Marlyn Meltzer, Frances Spence e Ruth Teitelbaum desempenharam um papel essencial no projeto, mas suas contribuições foram amplamente ignoradas por décadas.

Embora o ENIAC estivesse longe de ser eficiente ou prático pelos padrões atuais, ele abriu o caminho para a miniaturização e o desenvolvimento de computadores mais acessíveis. Sem ele, a trajetória que levou ao surgimento dos computadores pessoais seria muito diferente.

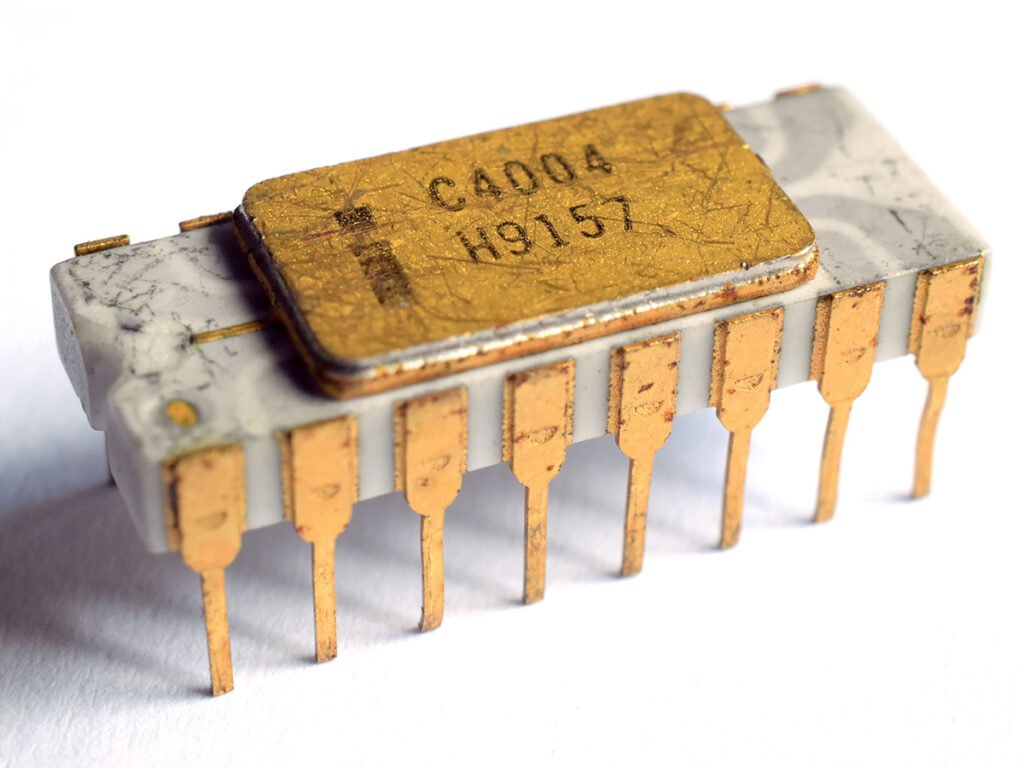

Reduzindo o tamanho: transistores, circuitos integrados e microprocessadores

Os primeiros computadores representaram um marco na história da tecnologia, mas também apresentavam grandes desafios. Além de serem enormes, essas máquinas eram extremamente custosas para operar. Seu sistema de válvulas a vácuo consumia uma quantidade exorbitante de energia e gerava muito calor, causando superaquecimento e frequentes falhas no funcionamento. Esses problemas deixaram claro que a miniaturização era essencial para o futuro da computação.

A solução começou a tomar forma na década de 1950, com a invenção dos transistores. Esses pequenos dispositivos semicondutores substituíram as válvulas a vácuo, oferecendo maior eficiência, confiabilidade e um consumo de energia consideravelmente menor. Embora os computadores da época ainda fossem grandes, os transistores marcaram o primeiro passo na redução de tamanho e abriram caminho para avanços mais significativos.

Em 1958, outro marco revolucionou a indústria: o surgimento dos circuitos integrados, ou microchips. Essa tecnologia unificava vários transistores em uma única peça, permitindo a construção de computadores menores, mais leves e mais rápidos.

Nos anos 1970, a miniaturização atingiu um novo patamar com o lançamento do primeiro microprocessador, o Intel 4004. Pela primeira vez, todas as funções essenciais de um processador central estavam reunidas em um único chip. Essa inovação não apenas reduziu drasticamente o tamanho dos computadores, mas também foi a base para a criação de computadores pessoais, dispositivos portáteis e, mais tarde, avanços como a interface gráfica e a Internet.

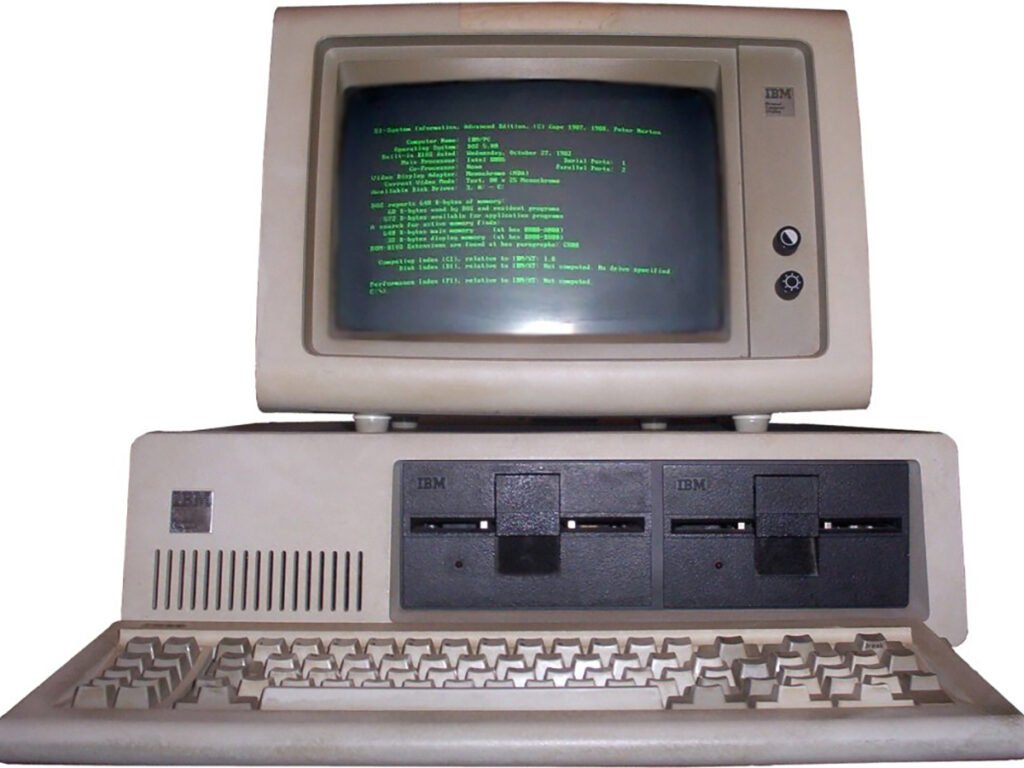

Um salto na tecnologia: O surgimento dos PCs

Em 1976, os estudantes Steve Jobs e Steve Wozniak lançaram o Apple I, um dos primeiros computadores voltados ao uso pessoal. Já no ano seguinte, a dupla apresentou o Apple II, que trouxe inovações como teclado integrado e capacidade de conexão com monitores, aproximando-se do design dos computadores atuais.

Outro grande avanço ocorreu em 1981, com o lançamento do IBM PC (Personal Computer). Equipado com o software PC-DOS – desenvolvido pela Microsoft e posteriormente conhecido como MS-DOS – o PC da IBM foi pioneiro no mercado e, apesar de seu alto custo, vendeu mais de 30 mil unidades em apenas quatro meses.

Em 1984, a Apple respondeu com o Macintosh, famoso por popularizar a interface gráfica amigável e o uso do mouse, tecnologias que revolucionaram a experiência do usuário.

Nos anos 1990, os computadores começaram a se conectar com impressoras, scanners e fax, enquanto a internet emergia como um elemento central na sociedade. Em 1995 uma nova peça foi adicionada aos PCs quando a NVIDIA lançou a primeira placa de vídeo dedicada, a NV1, que atendeu à crescente demanda por gráficos avançados em jogos para computador.

A partir desse momento, os computadores se tornaram indispensáveis, acompanhando as transformações do mercado com a chegada dos laptops, que trouxeram portabilidade e flexibilidade para usuários domésticos e empresariais.

O que o futuro nos reserva: Inteligência Artificial e Computação Quântica

O futuro da tecnologia é cada vez mais promissor, e a perspectiva da Computação Quântica e avanço da Inteligência Artificial são provas disso. Esses dois tópicos são tão relevantes que marcaram presença nas tendências tecnológicas do Gartner para 2025, deixando de ser uma ideia futurista e se tornando realidade.

A Computação Quântica se difere da computação que conhecemos pela sua maneira de processar os dados. Diferente dos computadores convencionais, que operam em bits binários (0 ou 1), os computadores quânticos utilizam qubits, que podem representar múltiplos estados simultaneamente, o que promete resolver problemas que demandariam milhões de anos em poucos segundos. O sucesso da Computação Quântica abrirá possibilidades para avanços em segurança digital, inteligência artificial e simulações científicas.

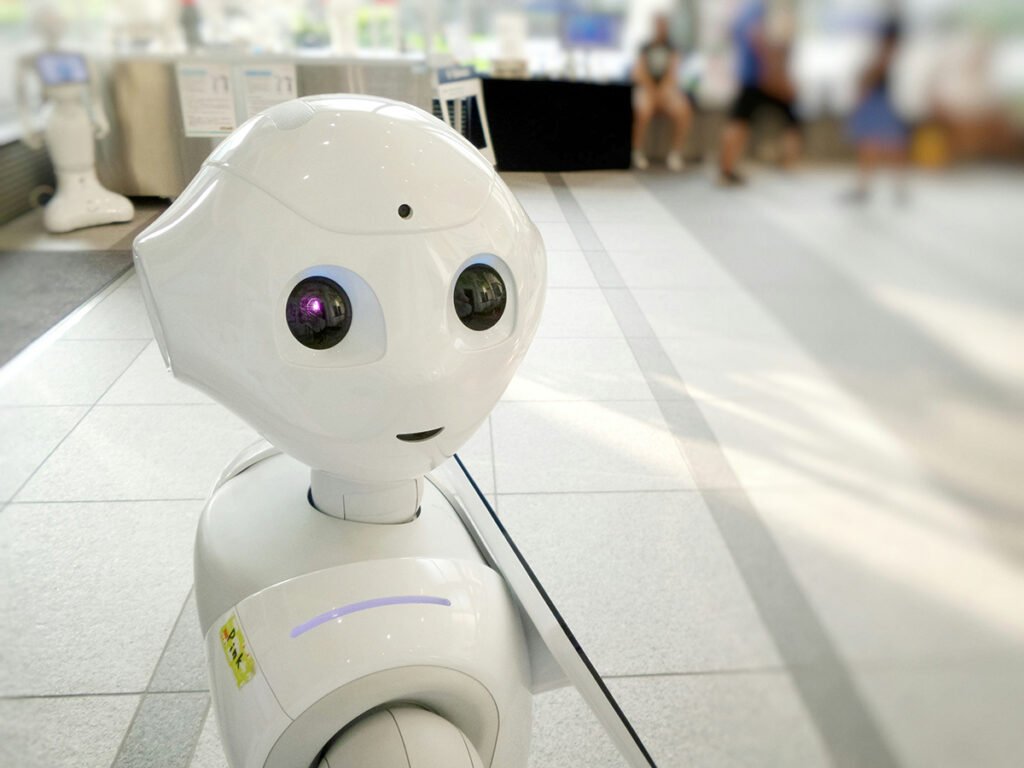

Já a Inteligência Artificial caminha a passos largos com o surgimento de assistentes virtuais cada vez mais intuitivos e conectados a dispositivos dentro de nossas casas. Além disso, os estudos em IA prometem avanços na medicina com diagnósticos mais precisos e em estágios iniciais das doenças, transformações na indústria com a automatização de tarefas repetitivas, impactos na mobilidade e nos transportes com o uso de veículos autônomos capazes de reduzir acidentes de trânsito etc.

Com esses dois campos de ponta avançando lado a lado, as possibilidades são quase infinitas. Estamos prestes a entrar em uma nova Era tecnológica, onde os limites de hoje serão as bases do amanhã.

Conclusão

A história dos computadores é um testemunho do engenho humano. O que começou como uma ferramenta para cálculos militares se transformou em uma tecnologia indispensável, moldando a maneira como vivemos, trabalhamos e nos conectamos com o mundo.

À medida que avançamos, a integração da tecnologia em nossas vidas só tende a crescer, trazendo inovações que mal podemos imaginar. Olhar para o passado nos ajuda a entender o presente e a sonhar com as possibilidades do futuro.

Esperamos que este artigo tenha ampliado sua compreensão sobre a evolução dos computadores e inspirado sua curiosidade para o que está por vir. Continue acompanhando nossos conteúdos e nos encontramos na próxima semana com mais novidades do universo digital!